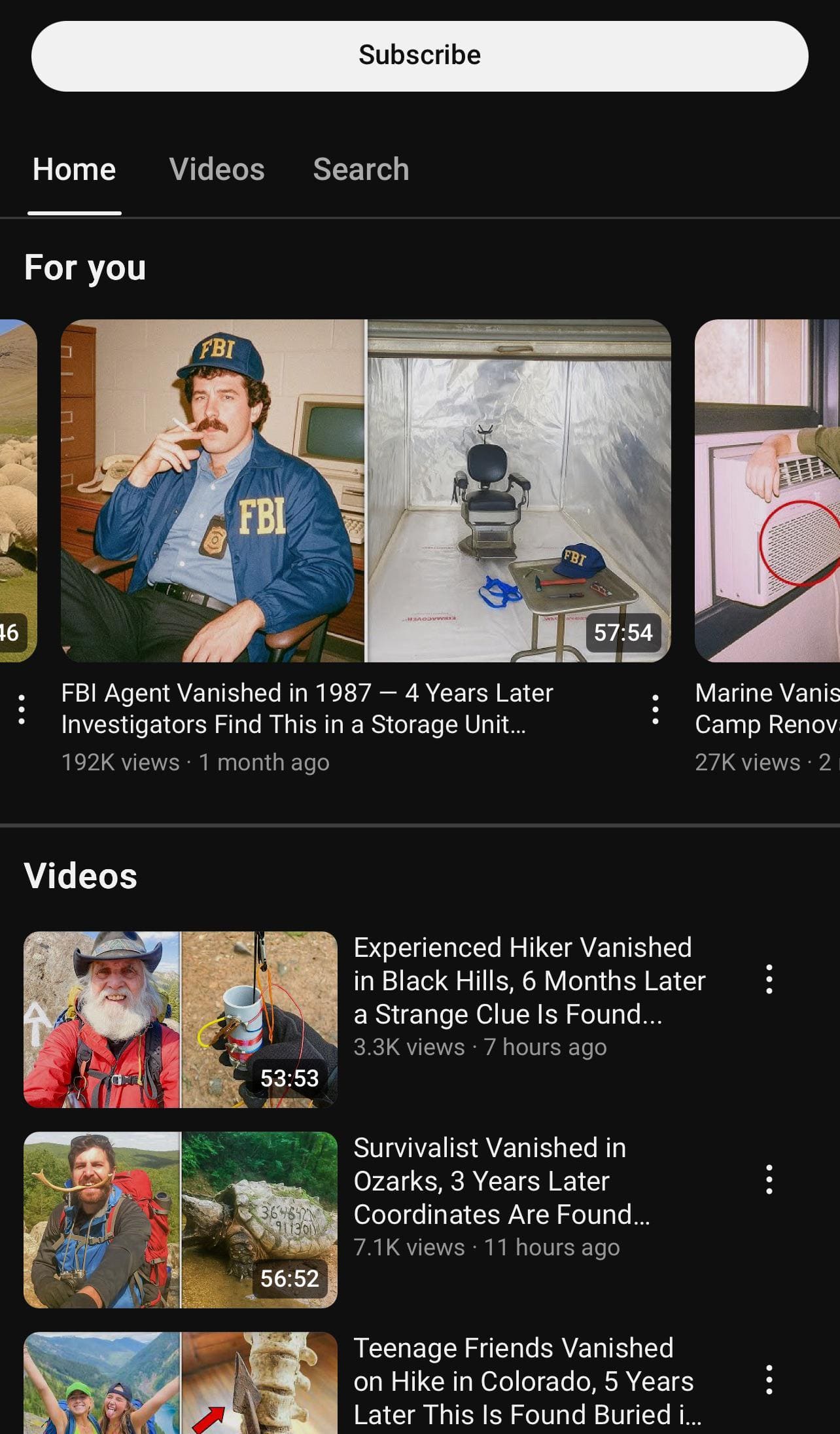

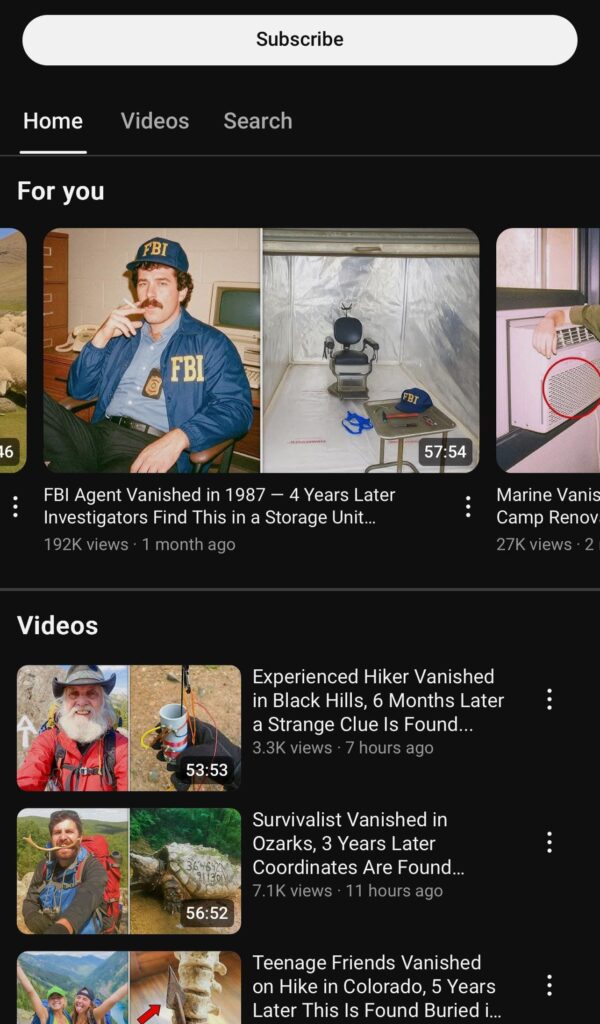

Ondata di True Crime generati dall’AI su Youtube: Come riconoscere le fake-story

Hai presente quei true crime super avvincenti… che poi scopri non essere mai successi? Capita a tutti. Nel feed Youtube ultimamente compaiono video confezionati come servizi TV, con titoli seri, voice-over “da TG” e grafiche perfette. È qui che la testa ci frega: se riconosci un dettaglio plausibile (una città reale, un’immagine d’archivio), ti fidi del resto. Ed è così che le fake news su YouTube scivolano nella tua memoria come se fossero cronaca vera.

Spoiler: non serve una crociata contro l’IA. Serve una policy sulla fiction chiara, visibile e coerente un’idea che negli ultimi mesi è entrata anche nella comunicazione ufficiale di YouTube sulle etichette per contenuti sintetici.

Ok, che sta succedendo?

Te la faccio semplice: i video generati dall’IA imitano ritmo, tono e “look&feel” di un telegiornale locale. A livello algoritmo, se un contenuto ti trattiene, YouTube te ne propone altri simili. Quindi, più guardi quel formato, più la home si riempie di storie “gemelle”. In breve: l’algoritmo di raccomandazione vede il tuo interesse e lo massimizza, senza chiedersi se quella storia sia verificata. È così che le fake news su YouTube iniziano a sembrare “la norma” nella tua bolla personale.

Quel che vedi convincente non lo è per magia, ma per design:

- ritmo narrativo da breaking news,

- grafiche e sottopancia da TV,

- dettagli verosimili (date e luoghi plausibili),

- voce sintetica pulita, senza esitazioni.

Quando questi elementi si incastrano, il cervello dice: “suona tutto giusto”.

Perché vedi così tanti “casi” inventati

Qui entra il “pacchetto completo”:

- Packaging professionale: B-roll generico, musiche di tensione, sottopancia “credibili”.

- Storytelling da cronaca: vittime e città “quasi reali”, ma zero riscontri pubblici.

- Commenti orchestrati: account che ripetono frasi tipo “nessuno ne parla”, “che schifo i media” per creare validazione sociale (spesso ci sono bot).

- Incentivi economici: più watch-time ⇒ più suggerimenti ⇒ più entrate pubblicitarie.

Non è teoria: diverse inchieste hanno mostrato serie “true crime” composte da casi mai accaduti eppure virali. Qui un approfondimento utile:

📄 Leggi su 404 Media – Inchiesta True Crime InventatiCome sgamarle in 30 secondi (e in 5 minuti, se serve)

Versione lampo (30″):

- Cerca fuori da YouTube. Esiste almeno una fonte locale attendibile (testata registrata, comunicato della polizia, registro pubblico)? Se no, sospendi il giudizio.

- Apri l’“About” del canale. Niente volto, nessun contatto, nessun link di redazione = allerta.

- Ascolta la voce. È troppo piatta, senza respiro, “perfettina”? Spesso è TTS.

- Leggi i commenti. Se sono tutti uguali o ultra-polarizzati dopo pochi minuti dalla pubblicazione, probabile “boost” di bot.

- Se il video parla di “contenuti manipolati o sintetici” senza dichiararlo, ricordagli le regole: YouTube spiega chiaramente come e quando fare disclosure nella sua guida ufficiale

Questa micro-routine ti fa evitare un mare di fake news su YouTube con un impegno minimo.

Perché è un problema (anche se ti senti smaliziato)

Non è una questione “da boomer”. Se vivi in bolle informative, la TV finta sembra TV vera. Queste storie si infilano nella memoria di lavoro e, col tempo, influenzano come valuti i rischi, come discuti di politica pubblica, come educhi tuo figlio alla distinzione tra vero e falso. Il bias di conferma lavora in silenzio: se il racconto combacia con ciò che già pensi, lo accetti volentieri. E nelle comunità con alfabetizzazione digitale più fragile il danno raddoppia, perché mancano gli strumenti per il fact-checking. Risultato: le fake news su YouTube cambiano davvero i comportamenti, non solo le opinioni.

La soluzione semplice: chiamarla fiction, sempre

Non dico “vietiamo l’IA”. Dico: chi fa narrativa la chiami fiction senza giri di parole, e le piattaforme lo rendano obbligatorio e visibile. Cosa significa in pratica?

- Bollino “Fiction” nel player, prima/durante/dopo, non solo una nota a fondo descrizione.

- Disclosure nel titolo (“Docu-fiction”, “Storia inventata basata su…”) e nella descrizione in prima riga.

- Tag/metadata standard, machine-readable, così motori di raccomandazione, parental control e filtri possono lavorare.

- Sanzioni progressive: se spacci narrativa per factual → segnalazione visibile, demonetizzazione, distribuzione ridotta.

- Docu-fiction ok, ma solo con bollino chiaro.

Mini-checklist (salvala, è il tuo paracadute)

- Prima di condividere: esiste una fonte indipendente (meglio se locale)?

- Nome e cognome: la vittima è identificabile e verificabile?

- Data e luogo: sono precisi o fumosi?

- Immagini: sembrano stock/B-roll riciclato?

- Commenti: c’è un coro strano e ripetitivo?

- Motivazione: condivido perché è vero… o perché mi dà ragione/mi fa arrabbiare?

Io voglio aiutarti a usare l’IA in modo etico. voglio aiutarti a usare l’IA in modo etico: automazioni utili sì, disinformazione no. Se ti va, scarica questa checklist nella tua app note e mettila come promemoria settimanale.

Diffida dei casi senza vittime nominative verificabili, senza forze dell’ordine citate, pieni di “fonti anonime”

Dipende dalle giurisdizioni e da come si presenta il contenuto. Il problema qui è l’etica e la trasparenza: chiamare fiction ciò che è fiction

Le piattaforme storicamente reagiscono a catena di incentivi e segnalazioni. Una policy di etichettatura fiction cambierebbe gli incentivi senza censurare

Attiva modalità con restrizioni, crea una piccola routine di fact-checking in famiglia e insegna le tre domande lampo. Le fake news su YouTube si battono con abitudini semplici